Toen AI-programma’s zoals Midjourney en DALL-E verschenen, dachten veel mensen dat de computer stiekem “knip-en-plak” werk deed met plaatjes van Google. De werkelijkheid is veel wonderlijker.

Deze programma’s creëren beelden pixel voor pixel vanuit het niets. Maar hoe leert een computer om te tekenen? Het antwoord ligt in een techniek die Diffusion (diffusie) heet.

Inhoudsopgave

De simpele uitleg: Kijken naar wolken

Voordat we de techniek in duiken, stel je dit voor: je ligt in het gras en kijkt naar de wolken. Wolken zijn willekeurige waterdamp (ruis). Maar jouw brein wil overal patronen in zien.

Jij zegt: “Hé, die wolk lijkt op een hond!”.

Stel je nu voor dat je een magische stift hebt. Je trekt de lijntjes van die ‘hond’ in de wolk over. Vervolgens gum je de rest van de wolk weg. Wat houd je over? Een tekening van een hond.

Dit is precies wat AI doet. Het begint met een scherm vol digitale ruis (sneeuw, zoals op een oude TV) en zoekt daarin naar patronen die matchen met jouw opdracht.

Hoe werkt het technisch? (Vernietigen en herstellen)

Om dit kunstje te leren, is de AI getraind met een spelletje dat twee kanten op werkt.

Stap 1: Forward Diffusion (Leren door te slopen)

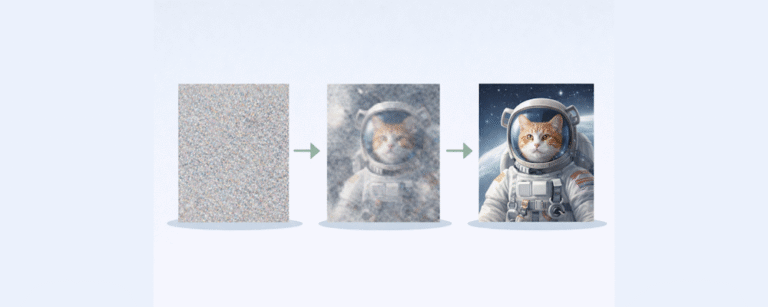

De computer krijgt miljoenen foto’s te zien, bijvoorbeeld van een kat. Stap voor stap gooit de computer ‘ruis’ over de foto heen.

Stap 1: Een beetje korrelig.

Stap 50: Erg wazig.

Stap 1000: Totale chaos. De kat is weg, er is alleen nog maar grijze ruis over.

Waarom doet de computer dit? Om te leren hoe de structuur van een kat langzaam oplost in chaos.

Stap 2: Reverse Diffusion (Het wonder)

Nu draaien we de film terug. De AI krijgt een bak met ruis en de opdracht: “Herstel de kat.”

Omdat de AI miljoenen keren heeft gezien hoe een kat in ruis verandert, kan hij nu wiskundig berekenen hoe hij de ruis weer terug moet veranderen in een kat. Hij ‘poetst’ de ruis weg en haalt het plaatje tevoorschijn.

Van Tekst naar Beeld

Als jij nu typt: “Een astronaut op een paard”, gebeurt er het volgende:

- De Start: De AI maakt een veld met willekeurige ruis aan.

- De Gids (Jouw Prompt): Jouw tekst wordt omgezet in getallen. Deze getallen fungeren als een zaklamp. Ze sturen de AI tijdens het ‘poetsen’.

- Het Proces: De AI begint de ruis weg te halen. De ‘zaklamp’ schijnt bij: “Zorg dat de pixels hier op een helm lijken, en daar op een paardenhoofd.”

- Het Resultaat: Na ongeveer 30 tot 50 stappen is de ruis weg en staat er een haarscherpe afbeelding die nog nooit eerder heeft bestaan.

Waarom gaat het zo snel?

Een foto bestaat uit miljoenen pixels. Als de computer voor elke pixel apart moet rekenen, duurt het genereren van één plaatje uren. Daarom gebruiken moderne systemen (zoals Stable Diffusion) een slimme truc: Latent Diffusion.

De AI werkt niet met de enorme foto, maar met een gecomprimeerde mini-versie (de Latent Space).

Vergelijk het met een architect: die bouwt niet meteen het hele huis, maar werkt eerst op een kleine bouwtekening. Pas als de tekening af is, wordt het opgeblazen naar het ware formaat. Hierdoor kun je tegenwoordig prachtige AI-kunst maken op een gewone laptop in plaats van een supercomputer.

Diffusion Models zijn eigenlijk ‘restaurateurs’. Ze zijn getraind om kapotte beelden (ruis) te herstellen. Door ze te sturen met tekst, kunnen we ze laten ‘hallucineren’: ze zien patronen in de chaos die wij ze opdragen te zien, en maken die werkelijkheid.