Het is de moderne versie van het kat-en-muisspel. Studenten gebruiken AI om essays te schrijven, trollen gebruiken het om nepnieuws te maken met levensechte foto’s, en criminelen klonen stemmen. Aan de andere kant proberen bedrijven als Turnitin, Google en Intel wanhopig software te bouwen die het onderscheid nog kan maken.

Maar hoe vang je een geest in een fles? AI-detectie is geen magie; het is zware wiskunde. In dit artikel duiken we diep in de techniek achter tekst-, beeld- en videodetectie en de strijd in het onderwijs.

Inhoudsopgave

Tekst detectie

Zoals eerder besproken kijken detectors niet naar de inhoud, maar naar statistiek. Een Large Language Model (LLM) is in de kern een voorspellingsmachine. Het kiest altijd het woord dat statistisch gezien de hoogste waarschijnlijkheid heeft.

De 3 Pijlers van Tekst-analyse

- Perplexity (Verwarring): Dit meet hoe “verrast” een statistisch model is door een tekst. Een lage perplexity betekent dat de tekst extreem voorspelbaar is (dus waarschijnlijk AI). Mensen schrijven rommeliger en onvoorspelbaarder (hoge perplexity).

- Burstiness (Ritme): AI is monotoon. Zinnen hebben vaak een vergelijkbare lengte en structuur. Mensen variëren: we schrijven een hele lange, complexe zin met veel komma’s, gevolgd door een korte zin. Bam. Die variatie heet ‘Burstiness’.

- N-Grams analyse: Dit is de technische term voor woordreeksen. Detectors scannen naar vaste combinaties van woorden (N-grams) die vaak voorkomen in de trainingsdata van de AI. Als een tekst voor 90% uit veelvoorkomende N-grams bestaat, gaan de alarmbellen af.

De Oorlog in het klaslokaal

Voor scholen en universiteiten is AI een nachtmerrie. Tools als Turnitin (veel gebruikt in het hoger onderwijs) en GPTZero claimen AI te kunnen detecteren. Maar dit is niet zonder controverse.

Het probleem van ‘False Positives’

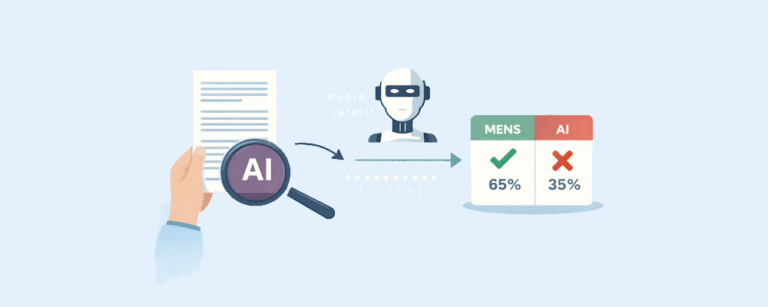

Een detector geeft nooit een “Ja” of “Nee”, maar een percentage: “Er is 84% kans dat dit door AI is geschreven”. Scholen interpreteren dit soms als hard bewijs, met rampzalige gevolgen.

Onderzoek (o.a. van Stanford) toont aan dat detectors bevooroordeeld zijn (bias):

| Groep | Risico op onterechte beschuldiging | Oorzaak |

|---|---|---|

| Niet-moedertaalsprekers | Extreem hoog | Mensen die Engels (of Nederlands) als tweede taal schrijven, gebruiken vaak eenvoudigere woorden en standaard zinsconstructies. Voor een detector lijkt dit statistisch gezien op AI. |

| Neurodivergente schrijvers | Gemiddeld tot hoog | Mensen met autisme kunnen soms een zeer formele, gestructureerde en feitelijke schrijfstijl hebben, wat door algoritmes verward kan worden met machine-taal. |

De tegenaanval: ‘Humanizers’

Studenten zitten niet stil. Er zijn inmiddels tools (“Humanizers” of “Paraphrasers” zoals Quillbot) die een AI-tekst herschrijven om de statistische patronen te doorbreken. Ze voegen expres foutjes toe, veranderen zinsstructuren en verhogen kunstmatig de ‘Burstiness’ om detectors te misleiden.

Beeldherkenning (Pixel-analyse)

Waar tekst draait om woordvolgorde, draait beelddetectie om pixels en ruis. Plaatjesgeneratoren zoals Midjourney en DALL-E 3 zijn gebaseerd op Diffusion Models. Die beginnen met ruis en bouwen daar een plaatje uit.

1. Visuele Artefacten (Wat het menselijk oog ziet)

In het begin keken we naar handen (6 vingers) of tekst (wartaal op uithangborden). Maar AI wordt beter. Tegenwoordig kijken experts naar:

- Glans en Belichting: AI-huid heeft vaak een onnatuurlijke ‘plastic’ glans (subsurface scattering klopt net niet).

- Symmetrie: Pupillen zijn bij AI soms niet perfect rond, of de weerspiegeling in het linkeroog matcht niet met het rechteroog.

- Achtergrondlogica: AI focust op het hoofdonderwerp. De achtergrond bevat vaak architectonische fouten (trappen die nergens heen gaan, tegels die vervagen).

2. Frequentie-analyse (Wat de computer ziet)

Een echte foto, gemaakt met een camera, bevat specifieke sensor-ruis (grain). Een AI-afbeelding heeft dit niet, maar bevat wel residuele ruis van het diffusie-proces.

Software kan een afbeelding omzetten naar het “frequentie-domein” (Fourier Transform). Hierin wordt zichtbaar of de pixels een natuurlijk patroon volgen of een wiskundig gegenereerd raster. Dit is voor het blote oog onzichtbaar, maar voor software een duidelijk signaal.

De toekomst van de waarheid (C2PA)

Omdat detectie achter de feiten aan blijft lopen (het is een wapenwedloop), werkt de tech-industrie aan een andere oplossing: Authenticatie in plaats van detectie.

Dit heet de C2PA-standaard (Content Credentials).

Hoe werkt het?

Camera’s (van bijv. Sony of Leica) en software (zoals Photoshop) voegen een onvervalsbaar, cryptografisch watermerk toe aan de metadata van een bestand. Dit certificaat zegt: “Deze foto is op dat moment gemaakt door deze camera en is niet bewerkt door AI.”

AI-detectie is geen leugendetector die rood of groen licht geeft. Het is een kansberekening. Bij tekst is het onbetrouwbaar en riskant om mensen op te beoordelen. Bij beeld is het (voorlopig) nog iets makkelijker door wiskundige patronen in de pixels, maar ook daar vervaagt de grens snel. In de toekomst zullen we niet meer vragen “Is dit nep?”, maar “Kan ik bewijzen dat dit echt is?”.